TorchV AI v1.0发布

经过一个忙碌的3月,2024年4月1日,我们迎来了2024年1月26日首次发版以来最大的一次更新,TorchV AI(原TorchV Bot)从原来的beta 版本升级到了正式版v1.0。

目前TorchV AI的主要技术架构依然还是RAG+LLM,实现的是”快思考“的功能。再往后,我们会在TorchV AI中逐步增加”慢思考“的功能,既更加面向业务的Agent和Workflow。

以下是TorchV AI v1.0的主要更新升级内容:

- 整体检索能力有显著提升:

- Rerank策略重大优化,召回率更大;

- 表格处理能力重大优化,表格内容识别和计算能力增强;

- 提取解析能力升级:

- Chunking策略优化,针对文件内容疏密程度使用不同chunking方法;

- 搭建OCR服务器,优化含图片类型文件的提取解析能力;

- Word解析bug修复,内部表格提取能力加强;

- 应用中心全新发布:

- 新增应用中心大板块,用户可创建不同应用,废弃原来APIKey的直连方式;

- 应用内容增加仅限当前应用的参数配置和调试窗(Playground)功能,支持发布调试后的配置;

- 增加”一键嵌入“功能,引入几行js代码,即可在网站上实现AI问答服务。

您依然可以申请TorchV AI的试用,直接加微信(lxdhdgss)联系即可!

新版官网上线

这次我们同步也上线了最新版的官网,您可以复制https://www.torchv.com查看,或者点击文章最底部左侧的”查看原文“直接进入。

新版官网主要提供了:

- TorchV AI的介绍,并且我们还会不断完善;

- TorchV AI的主要功能和优势,如六个助力企业快速落地AI应用的组件,六个主要优势;

- 一些使用场景(产品)的介绍;

- 文档中心发布,包括Getting Started、用户手册、价格、产品发布日志和开发者文档等;

- 当然,还有技术Blog,后续会由我们的多位技术人员进行发布;

- 另外是团队成员的首次对外介绍。

还有就是我们也在官网增加了”一键嵌入“功能,您也可以进行尝试咨询。

附录:TorchV AI v1.0 用户手册-快速入门

该文件可以在官网的文档中心找到,在这里先一睹为快。

1.引言

省略…

2.快速开始

TorchV AI包含了诸多企业AI应用搭建的功能,但从快速使用来说其实只需三步:

- 创建和维护知识库;

- 使用Chatbot开始试用,如果您只是进行试用,到此已经完成了;

- 如果您想将TorchV AI 提供的能力接入到您自己的应用中,还可以创建和管理

应用。

好,接下来我们一起用5分钟了解如何快速使用。

2.1 创建和维护知识库

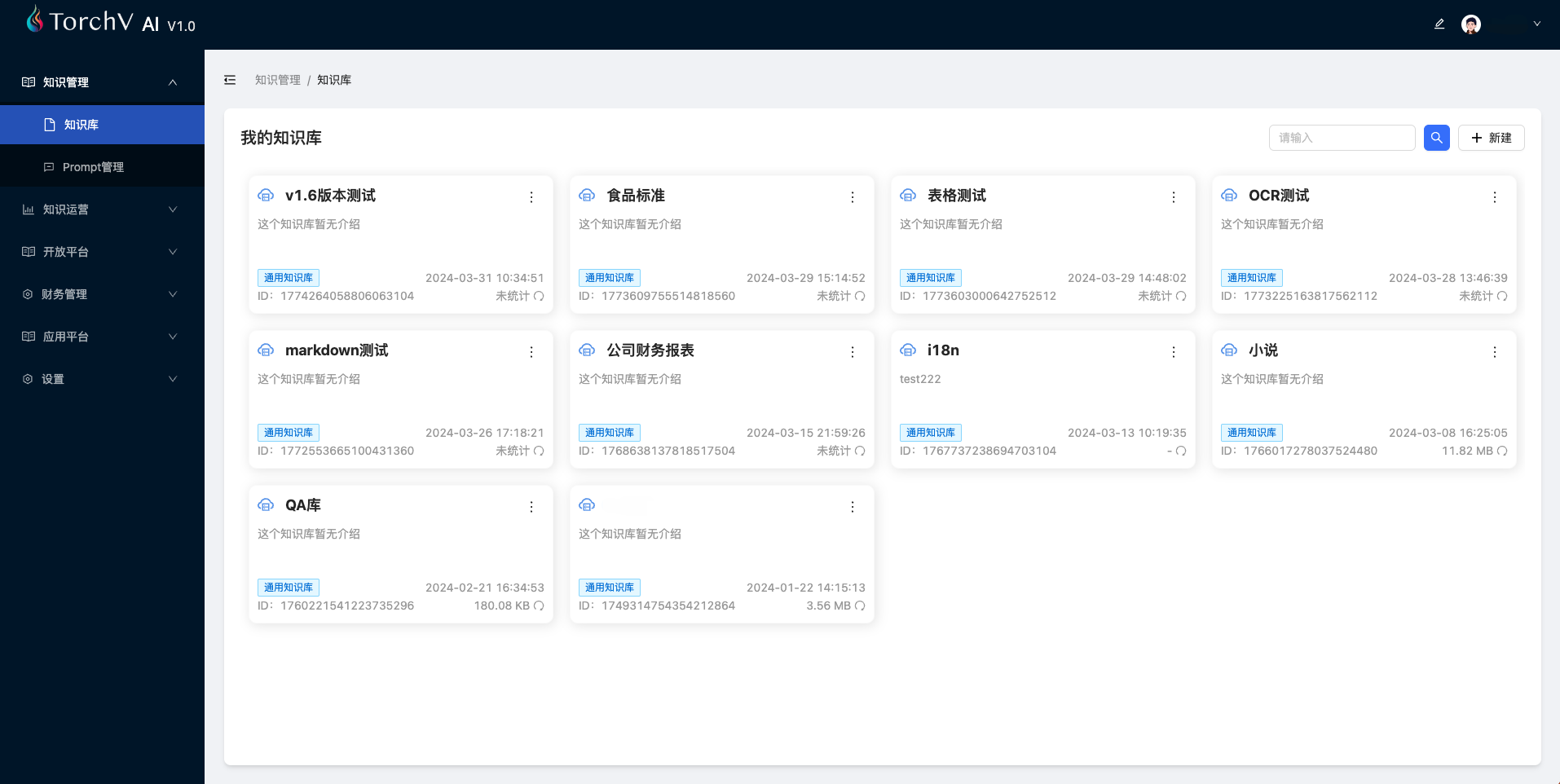

Path:知识管理 —> 知识库

图1:知识库

在知识库板块,您可以创建多个知识库,如“财务知识库”、“销售知识库”、“人才知识库”等等。区分知识库的目的是为了在后面提到的应用中能为每个应用绑定不同的知识库,让各个应用可以服务不同类型的用户。

2.1.1 创建知识库

您可以点击右上角的+新建新建知识库。

图2:创建知识库

目前我们只开放通用知识库,后续会增加另外三种知识库的创建:

- Web站点同步:其实使用一个网页URL创建知识库的方式已经实现,这里更多的是指定一个网站(site)的域名,准实时同步网站的新增内容。该功能仅限于单个网站内部抓取,且网站需要被认证为用户所有(一般通过CNAME方式进行验证);

- 关系型/NoSQL数据库:会首先进行ETL过程,如数据库链接测试、表格选取、schema复制等,然后建立loading计划,进行关系型数据库/NoSQL数据库的数据抽取;

- API GET操作:可以根据用户提供的API进行数据抽取和同步,维护知识库的数据更新。

OK,这些是后续的功能,这里我们可以先不关注,下面先来看看创建了知识库之后的内容。

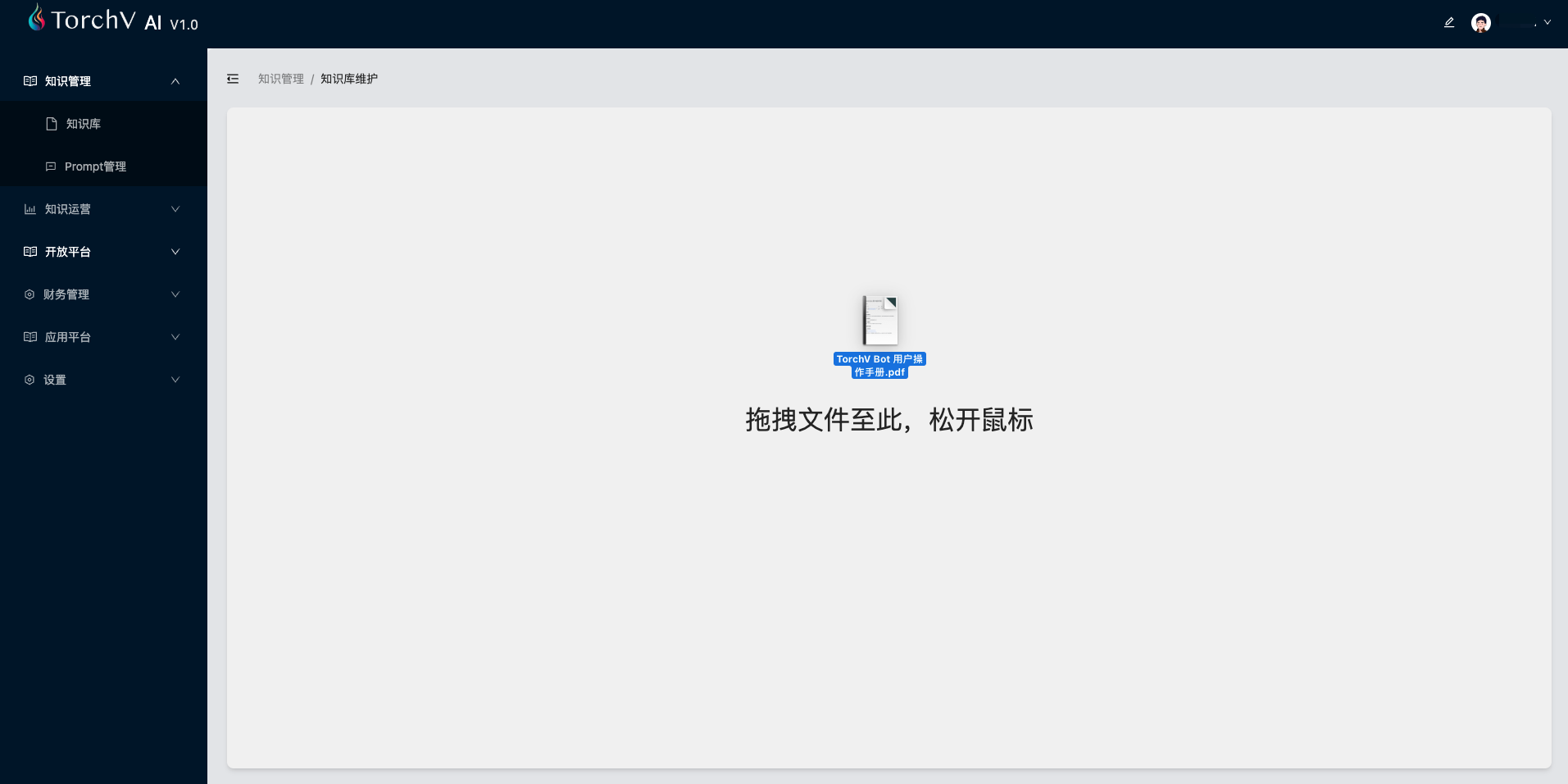

2.1.2 维护知识库

这里您应该看到我们刚刚创建的知识库开启第一个知识库的界面,空空如也。如果您想上传一个PDF先试试手,这时候您可以从桌面直接拖拽一个文件到当前页面。

图3:将文件拖拽到知识库页面即可上传文件。

下一步您将看到的就是刚才被拖拽的文件被分解(预览),在该界面我们首先可以查看文件是否被系统正常分块处理预览,一般提供前10页的预览。另外您也可以为文件设置生效时间,如让特定文件在次月1日生效,次月30日失效(不再提供该内容的对话、检索),默认是永久生效,既从文件处理完成开始一直有效。

图4:文件分块处理预览

一旦点击“确认”按钮,文件将进入处理队列,接下来的一些处理流程如下:

- 等待调度程序从waitlist中将文件处理的程序激活;

- 文件元数据处理和记录;

- 综合考虑文件类型、内容疏密程度等多种因素对文件进行分块(chunking);

- 将分块之后的内容进行embedding处理;

- 建立索引,包括向量索引和BM25类型的倒排索引;

- 处理完成。

从下图5中也可以看到一般文件处理的状态更新过程,您可以点击..按钮进行刷新。

图5:处理过程的三个状态。其中处理中可能需要一些时间,特别针对较大的文件。

好了,我们的“快速开始”环节,知识库创建就算完成了。当然TorchV AI提供了多样化的知识库维护支持,包括多类型文件、从Web导入、手工创建QA、以及直接复制粘贴内容等。

更多细节,我们会在后文中详细展开讲解。

2.2 测试问答

Path:知识运营 —> 问答对话

在2.1 创建和维护知识库 章节中我们已经完成了第一个知识库的创建,接下来让我们来对它进行测试。

图6:TorchV AI内置的Chatbot界面,主要提供用户测试使用。

这里需要注意的是两块界面功能:

- 聊天窗口:在菜单栏的右侧可以看到

新建聊天按钮,点击可以创建新的聊天窗口。不同聊天窗口之间是不能共享上下文(Context)的,所以有时候如果您调整了一些系统参数之后,可以新建聊天窗口进行重新测试,避免效果被干扰; - 知识库选择:我们可以选择想要借助的知识库进行对话,可以选择全选,或指定其中一个知识库,在测试时请务必注意。

就像开头讲的,如果您只是测试TorchV AI的问答能力,基本上到此为止就差不多了。但是如果您想让TorchV AI可以帮助您的业务AI化,那么2.3 应用创建将会非常重要,我们也简单预览一下。

2.3 应用创建

Path:应用平台 —> 应用中心

2.3.1 创建应用

在应用中心界面的右上角点击+新建,创建你的第一个应用。

图7:创新应用

创建完成之后,可以在应用中心的应用列表中看到我们新创建的应用:我的第一个应用。

图8:应用中心

在应用卡片的底部我们可以看到对话调试、编辑、删除等快速功能按钮。

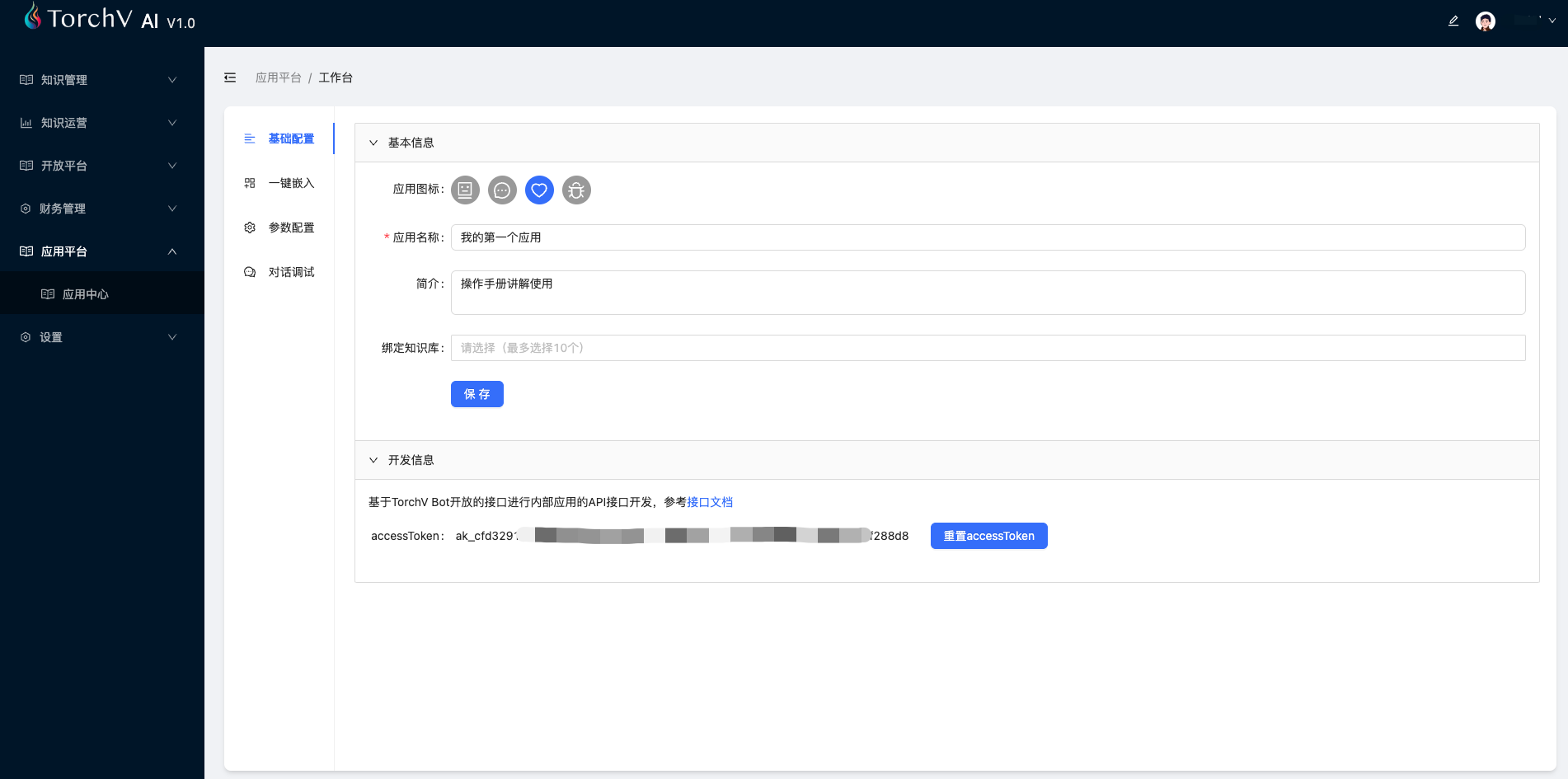

2.3.2 应用工作台

图9:应用的工作台(playground),提供应用的基础信息编辑、配置修改、一键嵌入功能和调试等功能。

2.3.2.1 基础配置

与图9中所示一样,这里不展开描述。

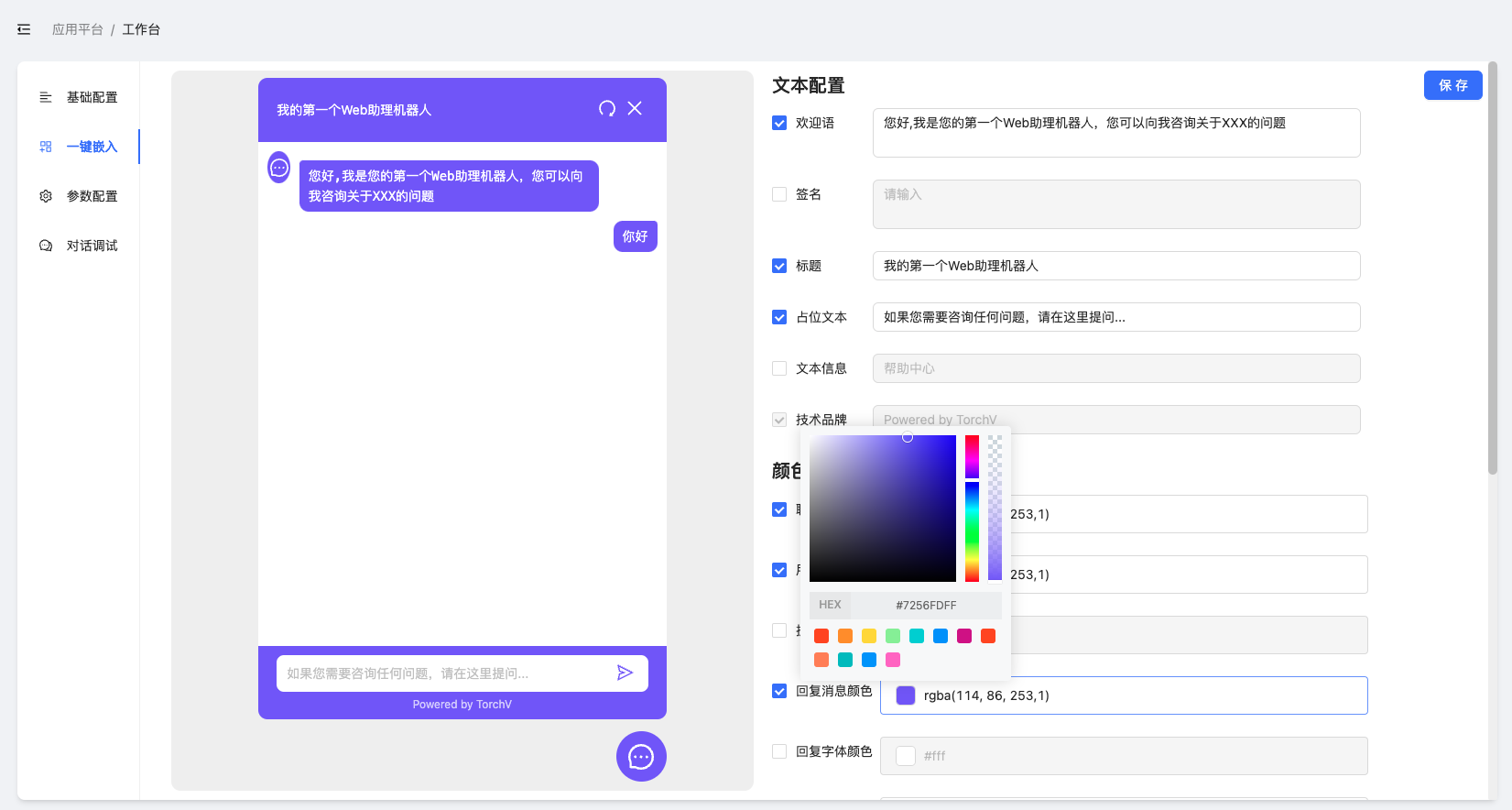

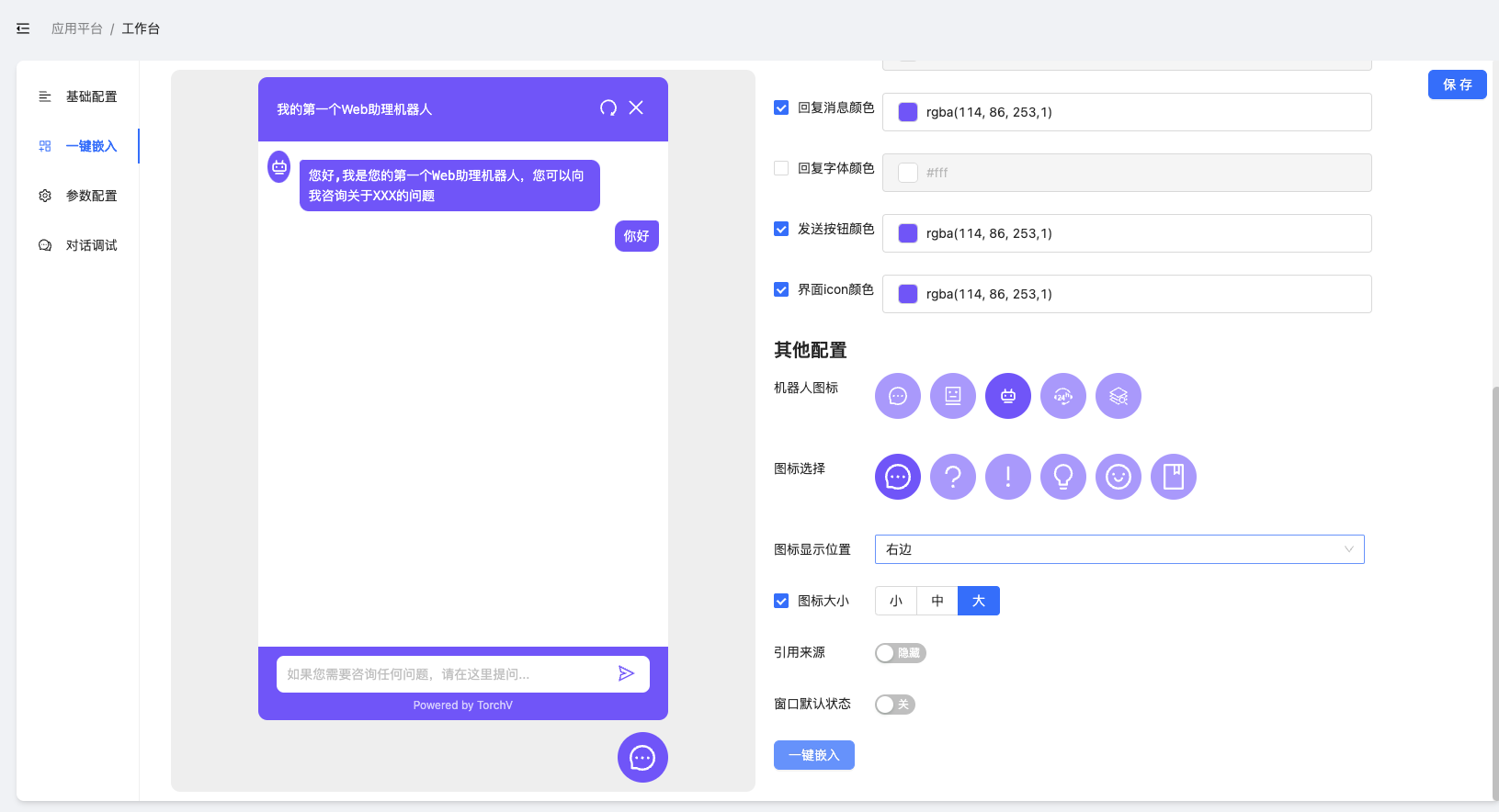

2.3.2.2 一键嵌入

一键嵌入的主要作用:快速将TorchV AI的chat能力嵌入到用户自己的官网、电商网站和Web版的业务系统中,整个过程只需复制几行js代码到目标系统/网站的Header中。

图10、图11:一键嵌入界面

我们在自己的官网做了一键嵌入,为访客提供咨询服务,知识库来源于TorchV概览(Getting-Started)和操作手册(Manual),下图是截图效果:

图12:TorchV官网的一键嵌入截图

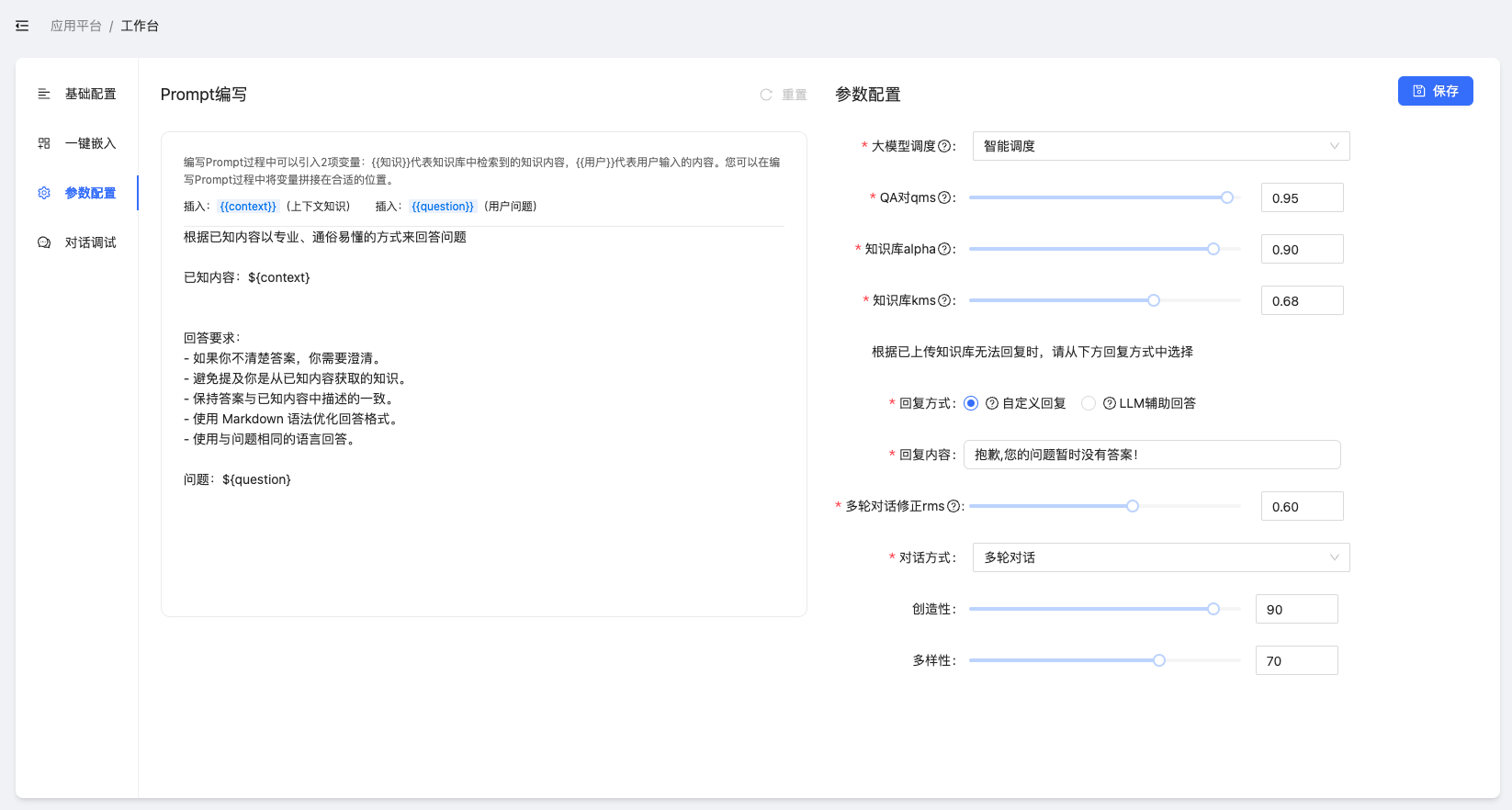

2.3.2.3 参数配置

图13:应用的参数配置

首先,这里的参数配置与知识管理-Prompt管理的界面几乎相同,但是权限范围不一样,应用中的参数配置仅作用于当前应用,而知识管理-Prompt管理则是全局默认配置,尤其对知识运营-问答对话起作用。

回到图10,我们可以看到当前应用的各类参数配置,主要配置项如下:

大模型调度(策略):- 默认是“智能调度”,会根据实际任务选择最合适的大语言模型进行处理,如即将送入大语言模型进行最后生成处理的的prompt文本长度超过其中几个大模型的上下文窗口长度(Context Length),那么智能调度将自动选择具备长上下文的大语言模型进行处理。后续版本还会在“智能调度”策略中加入外部MoE策略,在某些专项能力上更强的LLM来处理专项任务。

- 选择“自定义模型”则意味着由用户强行指定某个模型,具体模型包括

glm-3-turbo,glm-4, Baichuan2-Turbo,Baichuan2-Turbo-192k, qwen-72b-chat,qwen1.5-72b-chat, moonshot-v1-32k,moonshot-v1-128k, yi-34b-chat-200k。

QA对qms:QA对是传统FAQ的一种,QA对在系统中的优先级是最高的,qms指的是用户的问题(Qi)与QA对中的预设的问题(Qj)之间的相关度得分(取值0-1),如果这个相关度得分≥设定的qms数值(默认0.95),那么将直接介入QA回答的过程,后续的RAG过程将不再介入。QA对在常用语的维护中有非常好的效果,如“你是谁?”、“明天几点开门?”等比较固定的内容;知识库alpha:TorchV AI的RAG采用混合检索技术,alpha值为0则全部使用BM25检索(布尔检索、字面量检索占比更大),如果alpha值为1,则全部使用KNN检索(排序检索、基于向量相似度的语义检索);知识库kms:这应该是最重要的一个配置,RAG在检索文档时,会根据用户的问题(Q)去检索各个分块(chunks),再经过Rerank的交叉熵验证算法确定最终(与Q)的相关性得分。只有相关性得分≥kms分值的分块(chunks)才会被最终送入大语言模型进行生成处理:- kms取值在[0,1]之间,分值越高,则RAG检索的内容与Q越相关;

- kms最小值为0.5,默认kms在0.63-0.75之间,用户可根据需要调整;

- 对于问答比较严谨的场景,可以将

回复方式调整为自定义回复,而如果选择LLM辅助回答则会在回答内容中出现更多创造性内容,也可能是对用户造成困扰的幻觉(Hallucination)。

多轮对话修正rms:取值0-1,默认0.6。建议用户不要修改该分值。对话方式可以选择单轮或对轮。其他参数:- 创造性:既LLM的Temperature的参数,决定了LLM在输出下一个Token时的选择策略。创造性越大,LLM的下一个token输出越随机;创造性越小,则LLM的输出下一个token更倾向于逻辑上最可能的Token;

- 多样性:既LLM的Top-P参数,多样性参数越大,则LLM在潜在下一个输出的Token的可选范围越大,Top-P值是潜在Tokens的得分累计只和。

应用中的参数配置仅对该应用起到作用,所以用户可以在”对话调试“中根据不同场景调整参数配置,以获得最佳效果,别忘记”保存“。

2.3.2.4 对话调试

图14:对话调试功能

prompt编写

在图上可见,左侧最顶部是prompt编写,用户可以自行编写prompt模板,既RAG系统最终送给LLM的内容模板。其中的${context}是RAG在知识库中检索召回的最终内容,${question}是用户输入的最初问题。

在界面层面,只能维护一个prompt模板,也是默认生效的模板。但是如果您使用API进行应用开发,则可以在自己的应用中维护多个prompt模板,然后在不同的功能中将个性化prompt模板送入API的

promptTemplate属性中。一旦promptTemplate不为空,默认的prompt失效。

参数配置

与2.3.2.3 参数配置的内容一致,细节不再赘述。

但需要注意的是,在对话调整功能中的”参数配置“属于临时配置,调整之后即在右侧的预览调试中生效。但如果最终用户未点击”发布设置“,调整后的参数将会在关闭或跳转页面之后失效。如果用户点击了”发布设置“,则该配置参数会同步到2.3.2.3 参数配置中,覆盖原有配置。

知识库选择

在知识库选择的最右侧,点击+按钮进行知识库选择,可以进行多选。

图15:知识库选择,蓝色为已选择知识库。

只需点击弹出框外,就可以看到已经选择的知识库绑定:

图16:知识库绑定显示

2.4 快速开始总结

经过以上的知识库创建、问答测试和应用创建,您已经可以完成TorchV AI的全流程使用了,就是如此简单。

现在,您可以有以下方式使用TorchV AI:

- 在

知识运营—>问答对话中进行试用,但该方法适合于测试; - 创建自己的应用,使用一键嵌入功能,将TorchV AI的对话能力嵌入到您的官网或其他Web版系统中,这是对外释放能力最快的一种方式;

- 使用API对接您自己的应用,或者使用API创建新的应用,让您的更多客户享受到TorchV AI为您带来的AI能力。

Enjoy!