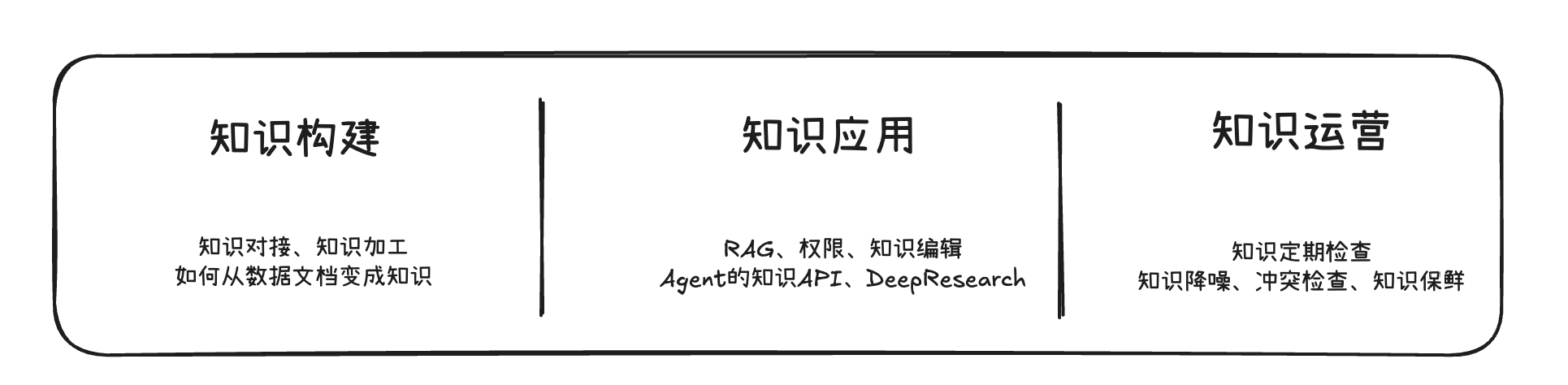

在企业AI落地实践中,数据/知识质量 是AI可靠性的基石。这一点可用一句俗语概括:垃圾进,垃圾出。如果输入给AI系统的是过时、混乱甚至错误的知识,那么AI输出必然难以令人满意。现实案例表明,不少企业最初构建的知识库缺乏质量管控,导致AI引用了错误版本的政策文件,给出了错误解答。之所以出现这种偏差,正是因为纯粹的技术方案缺乏对知识时效性、权威性的考量 。因此,在启动任何AI应用之前,企业必须先确保其知识语料“干净”和“新鲜”,为AI模型提供高质量、高可信度的知识原料 。正如TorchV AIS知识引擎所强调的,知识构建环节的使命就是从源头上解决“垃圾进,垃圾出”问题,确保进入AI系统的是高质量、高纯度的内容 。

知识需要被好好对待

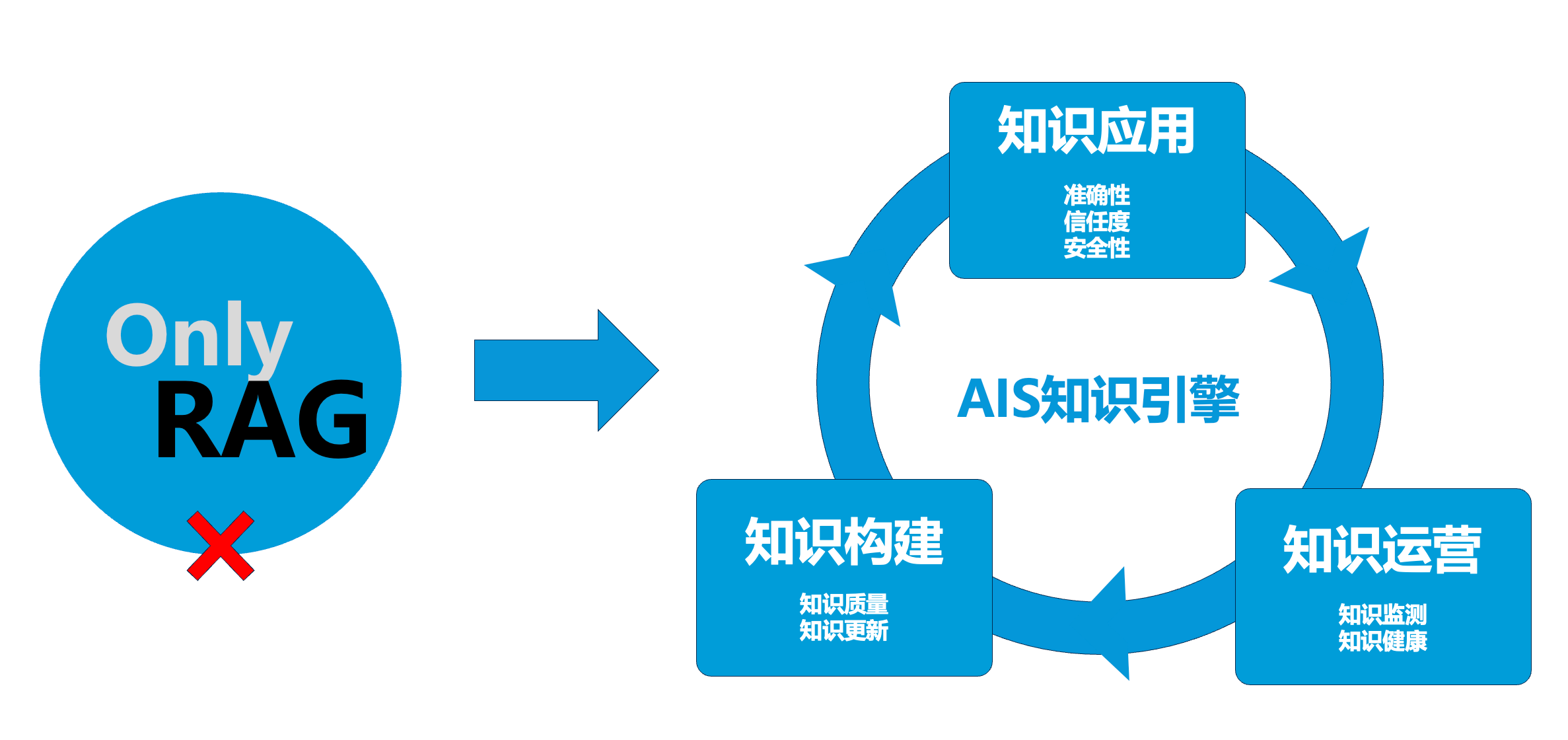

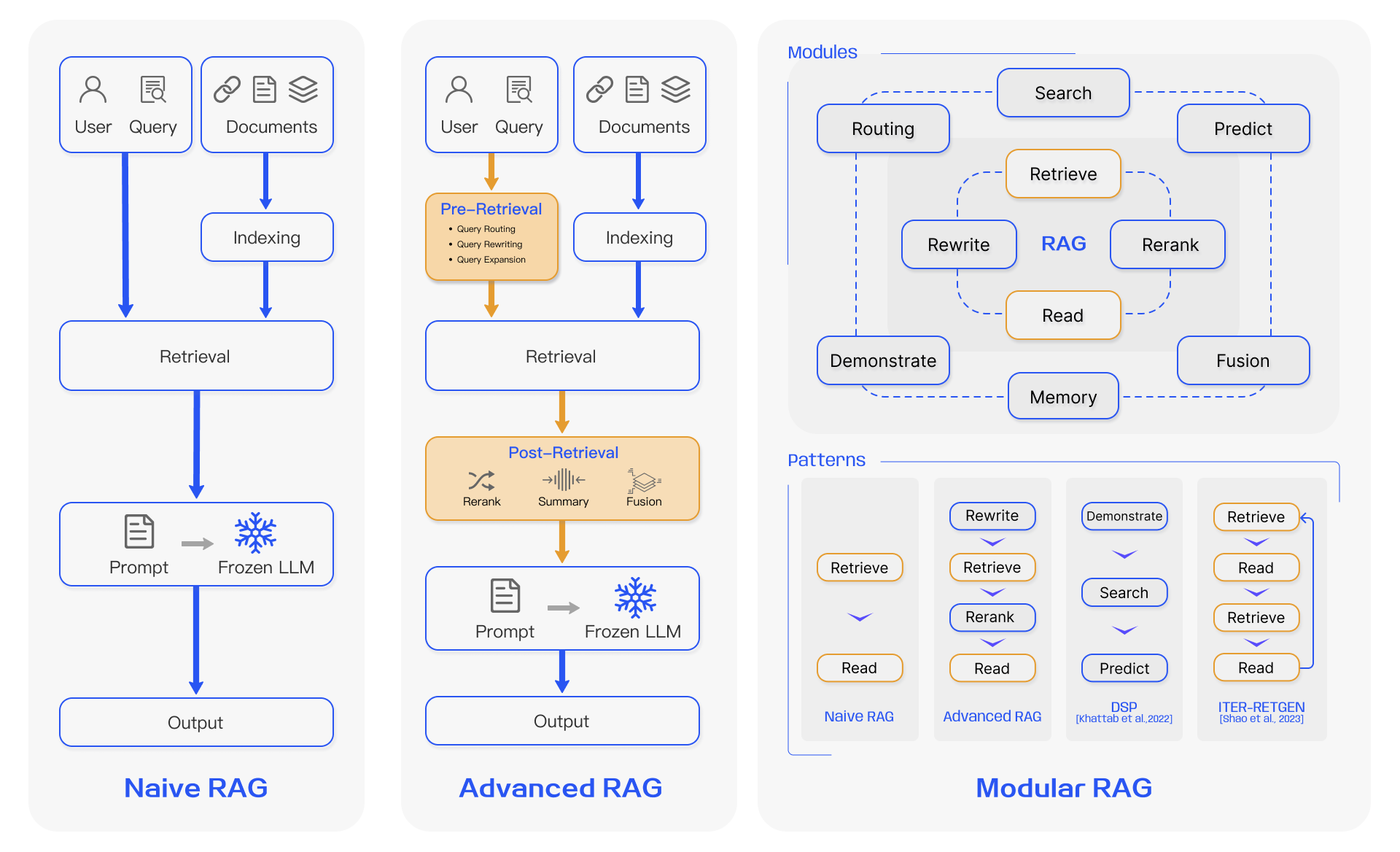

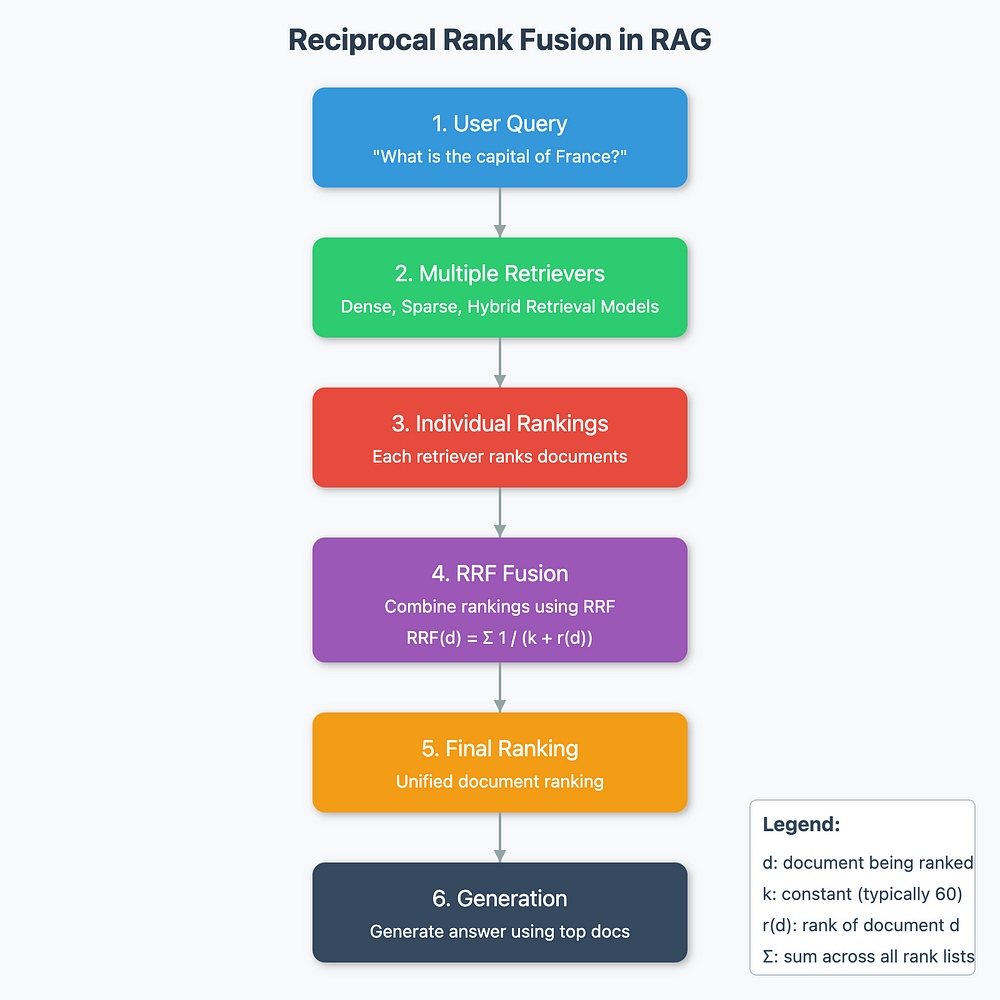

许多企业早期尝试采用 RAG方案,将大语言模型与企业内部知识库相结合,希望快速构建问答机器人。然而实践证明,RAG方案在生产环境中高达70%以失败告终 。造成失败的根源往往在于对知识管理缺乏系统性方法论,导致以下常见陷阱: